SAP

导航

jsp

lua metatable

整周模糊度

armv9

flink 最后一个窗口

嵌入式数据库

三星线刷

征文

素质模型

安卓毕设

k8s

华为面试

AsyncSequence

perl

bat批处理编程

2022年下半年

MMDetection

鲜花

LLMs

2024/4/11 21:57:26『大模型笔记』LLMs入门:从头理解与编码LLM的自注意力机制

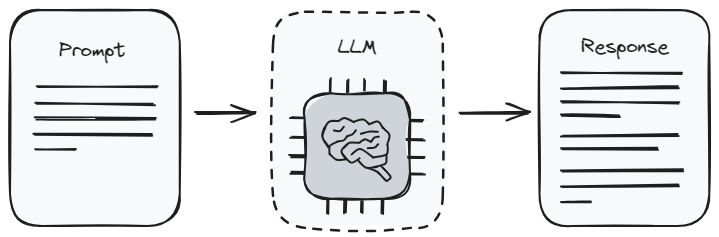

LLMs入门:从头理解与编码LLM的自注意力机制 这里直接引用我语雀上的的文章:《从头理解与编码LLM的自注意力机制》

Pyhon 大模型常见的微调方式,LLMs常见的Finetune方式;chatglm3微调实战;大模型微调通俗易懂总结

一、 LLMs微调 微调(Fine-tuning)是指在一个已经训练好的神经网络模型基础上,使用额外的数据集或调整超参数,以实现特定任务的训练过程。在微调中,通常会固定预训练模型的大部分参数,只调整最后几层或特定层…

『大模型笔记』吴恩达:AI 智能体工作流引领人工智能新趋势

吴恩达:AI 智能体工作流引领人工智能新趋势 文章目录 一. 概述二. AI 智能体的设计模式2.1. 反思(Reflection)2.2. 使用工具(Tool use)2.3. 规划(Planning)2.4. 多智能体协作(Multi-agent collaboration)三. 最后总结四. 参考文献一. 概述 我期待与大家分享我在 AI 智能体方面…

LLM之llm-viz:llm-viz(3D可视化GPT风格LLM)的简介、安装和使用方法、案例应用之详细攻略

LLM之llm-viz:llm-viz(3D可视化GPT风格LLM)的简介、安装和使用方法、案例应用之详细攻略 目录

llm-viz的简介

1、LLM可视化

2、CPU模拟(WIP;尚未公开!)

llm-viz的安装和使用方法

llm-viz的案例应用

1、三维可视化…

AI:人工智能领域AI工具产品集合分门别类(文本类、图片类、视频类、音频类、多模态类)的简介、使用方法(持续更新)之详细攻略

AI:人工智能领域AI工具产品集合分门别类(文本类、图片类、视频类、音频类、多模态类)的简介、使用方法(持续更新)之详细攻略 导读:由于ChatGPT、GPT-4近期火爆整个互联网,掀起了人工智能相关的二次开发应用的热潮,博主同时也应广大…

LLMs:《Efficient and Effective Text Encoding for Chinese LLaMA and Alpaca》翻译与解读

LLMs:《Efficient and Effective Text Encoding for Chinese LLaMA and Alpaca》翻译与解读 目录

相关文章

LLMs:《Efficient and Effective Text Encoding for Chinese LLaMA and Alpaca》翻译与解读

LLMs:在单机CPUWindows系统上实现中文…

ArXiv| Graph-Toolformer: 基于ChatGPT增强提示以赋予大语言模型图数据推理能力

ArXiv| Graph-Toolformer: 基于ChatGPT增强提示以赋予大语言模型图数据推理能力. 来自加利福利亚大学戴维斯分校计算机科学系的IFM实验室发表在arXiv上的文章:“Graph-ToolFormer: To Empower LLMs with Graph Reasoning Ability via Prompt Augmented by ChatGPT”。

文章的…

『大模型笔记』大模型微调(Fine-Tuning)还有价值吗?

大模型微调(Fine-Tuning)还有价值吗? 文章目录 一. 大模型微调(Fine-Tuning)还有价值吗?二. 总结三. 参考文献对最近微调幻灭趋势的反应。一. 大模型微调(Fine-Tuning)还有价值吗? 我深入研究后发现,微调技术在众多场景下仍然极具价值。通常认为微调无益的人,往往是那些在…

大模型开发工程师的成长路径(此篇文章持续更新)

导言:现在大模型如日中天,引起广大技术圈的强烈关注,现在投身于大模型开发,就是第一批的大模型开发工程师,必然能享受到行业内的先行者优势和红利。

我就是个俗人,工资待遇这么高,肯定要转行啊…

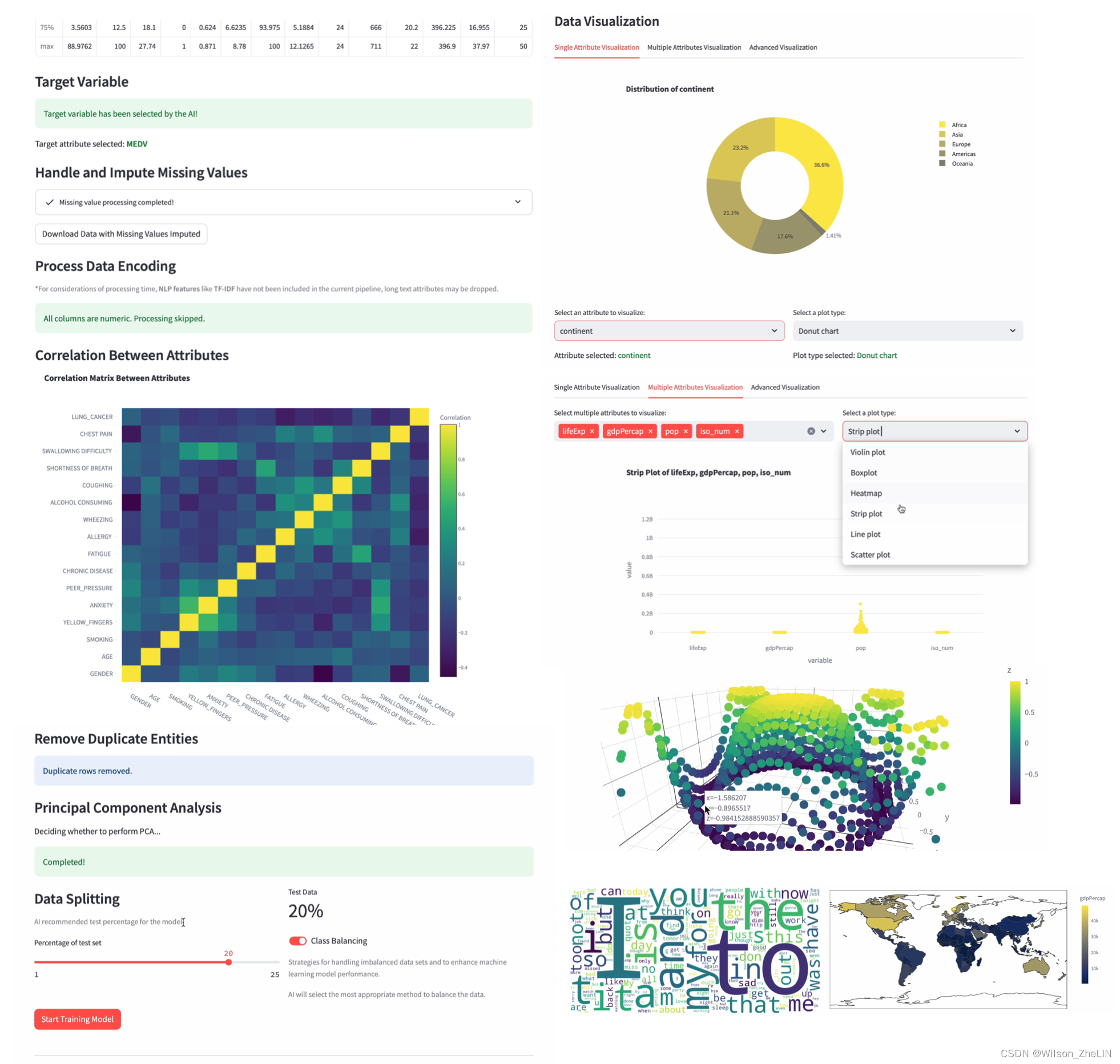

基于GPT-4一键完成数据分析全流程的AI Agent: Streamline Analyst

大型语言模型(LLM)的兴起不仅为获取知识和解决问题开辟了新的可能性,而且催生了一些新型智能系统,例如旨在辅助用户完成特定任务的AI Copilot以及旨在自动化和自主执行复杂任务的AI Agent,使得编程、创作等任务变得高效…

『大模型笔记』提示工程、微调和RAG之间对比

提示工程、微调和RAG之间对比 文章目录 一. 提示工程、微调和RAG之间对比二. 参考文章文章:Prompt Engineering vs Finetuning vs RAG一. 提示工程、微调和RAG之间对比 Prompt EngineeringFinetuning

『大模型笔记』混合专家模型(Mixed Expert Models,简称 MoEs)

混合专家模型(Mixed Expert Models,MoE) 文章目录 1. 什么是混合专家模型?2. MoE的PyTorch示例代码3. MoE优缺点4. 参考文章混合专家模型(Mixed Expert Models,MoE)1. 什么是混合专家模型?

2. MoE的PyTorch示例代码

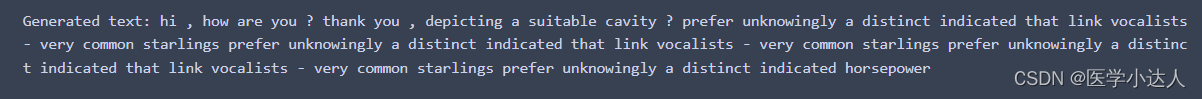

Python 自己训练chatGPT,实例代码如下;简单易懂的训练chatGPT,模板实例;自己训练chatGPT

代码实例:

比较简单的示例,其它gpt架构相关知识和代码移步专栏其它文章。

from torchtext.datasets import WikiText2 # 导入WikiText2

from torchtext.data.utils import get_tokenizer # 导入Tokenizer分词工具

from torchtext.vocab import build_…

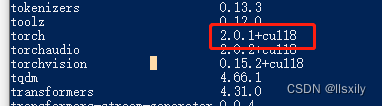

通义千问本地化部署不调用GPU只调用CPU的检查方法

今天部署本地版通义千问的时候遇到一个问题。 启动他的cli_demo.py调用的一直都是CPU模式的。 检查cuda已经正确安装,后面发现是torch即PyTorch的安装问题。

我安装torch的时候,用的是默认指令,没有增加别的参数。

检测一下,输出…

基于GPT一键完成数据分析全流程的AI Agent: Streamline Analyst

大型语言模型(LLM)的兴起不仅为获取知识和解决问题开辟了新的可能性,而且催生了一些新型智能系统,例如旨在辅助用户完成特定任务的AI Copilot以及旨在自动化和自主执行复杂任务的AI Agent,使得编程、创作等任务变得高效…

LLMs之ChatGLM3:ChatGLM3/ChatGLM3-6B的简介(多阶段增强+多模态理解+AgentTuning技术)、安装、使用方法之详细攻略

LLMs之ChatGLM3:ChatGLM3/ChatGLM3-6B的简介(多阶段增强多模态理解AgentTuning技术)、安装、使用方法之详细攻略 导读:2023年10月27日,智谱AI在2023中国计算机大会上推出了全自研的第三代基座大模型ChatGLM3及其相关系列产品,这是…

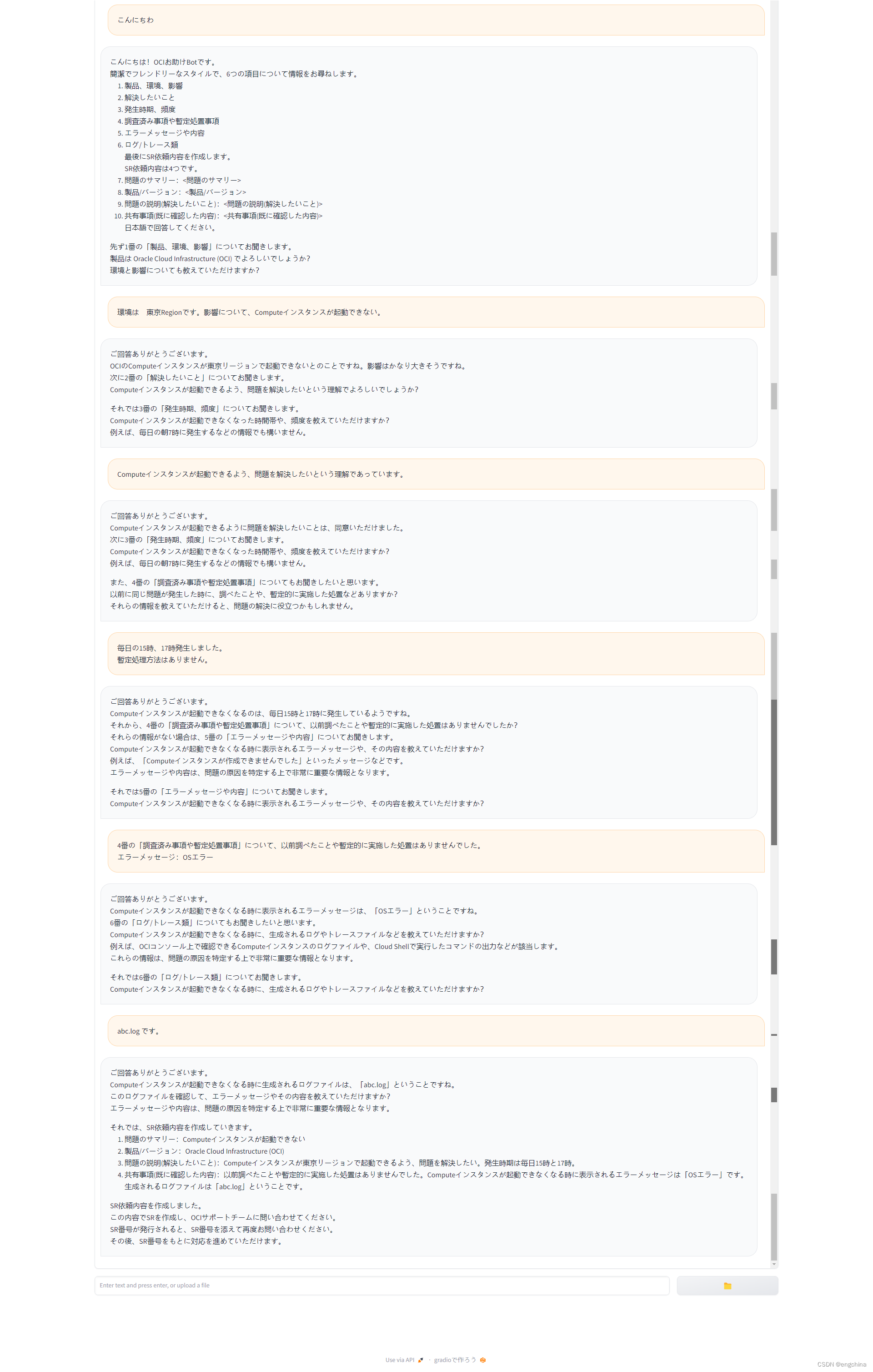

用开源大语言模型开发的智能对话机器人初版原型验证

用开源大语言模型开发的智能对话机器人初版原型验证 0. 背景1. 初版检证效果展示2. 验证效果总结 0. 背景

同事要想做一个智能对话机器人,特别的需求有有些几点,

通过预置提示词(包括确认事项),让大语言模型用会话式…

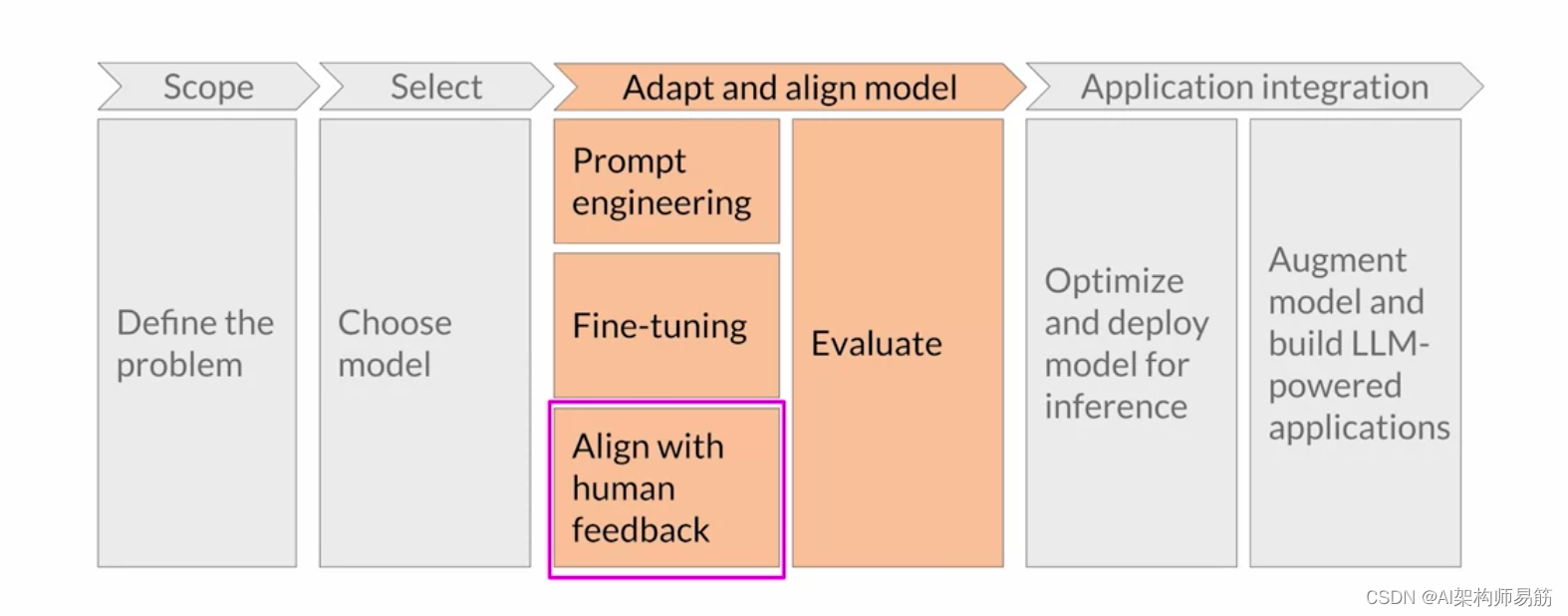

LLMS: 将模型与人类价值观对齐Aligning models with human values

欢迎回来。让我们回到 生成式 AI 项目的生命周期。

上周,你 仔细研究了一种叫做微调的技术。 使用 指令(包括路径方法)进行微调的目标是 进一步训练 模型,以便它们更好地理解 类似人类的提示并 生成更多类似人类的响应。

与基…